Po stworzeniu naszej nowej strony internetowej www.KompasArtStudio.pl, z niecierpliwością czekaliśmy aż zacznie ona pojawiać się w wynikach wyszukiwania GOOGLE. Ale mijały dni, tygodnie, a link do naszej strony nadal nie pojawiał się w wynikach naturalnych GOOGLE. Informatycy mówili nam, że to normalne, że trzeba czekać nawet kilka tygodni, że GOOGLE jest nieprzewidywalny itp. Ale ja czułam, że coś jest nie tak.

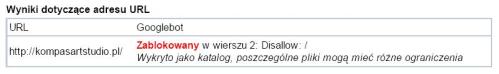

Przełom nastąpił na szkoleniu, organizowanym przez GOOGLE, na którym Mariusz Gąsiewski tłumaczył, że jednym z powodów braku indeksacji strony może być plik robots.txt. Jeszcze tego samego dnia w narzędziach dla webmasterów sprawdziłam jak wygląda nasz plik robots.txt i okazało się, że to on blokuje indeksację naszej strony.

Po zmodyfikowaniu pliku robots.txt i przeprowadzeniu ponownej analizy dla adresu http://kompasartstudio.pl/, otrzymaliśmy potwierdzenie, że nasza strona została odblokowana i powinna się wyświetlać w wynikach GOOGLE.

Jednak nasza strona nadal nie wyświetlała się w GOOGLE …

Zaczęliśmy analizować wszystkie ustawienia w panelu administracyjnym strony i okazało się, że popełniliśmy jeden z najbardziej banalnych błędów … W ustawieniach prywatności strony nie zmieniliśmy ustawień domyślnych i mieliśmy zaznaczoną opcję: Chcę blokować wyszukiwarki, ale jednocześnie dopuszczać zwykłych gości.

Po zmianie ustawień, nasza strona zaczęła się w końcu wyświetlać w wynikach naturalnych GOOGLE.

Straciliśmy wiele tygodni, zanim zdiagnozowaliśmy przyczyny blokowania indeksacji naszej strony w wyszukiwarkach.

Dlatego zaraz po stworzeniu strony WWW, należy przede wszystkim:

- zanalizować plik robots.txt

- sprawdzić ustawienia prywatności w panelu administracyjnym strony

Ee nie sadze zeby robots.txt byl tu glownym powodem. Tutaj np http://androidinfo.pl/robots.txt tez jest disallow a pomimo to strona wyswietla sie w google.